D’après « 2001 l’Odyssée de l’Espace », nos ordinateurs devraient comprendre notre voix depuis 9 ans. Depuis 1997, on trouve des logiciels de reconnaissance vocale pour PC, et depuis peu nos téléphones disposent de cette fonction. Mais on ne l’utilise pas. Je ne connais personne qui dicte ses e-mails, et vous ?

Comme tous les geeks j’ai essayé de temps en temps, parfois passé une heure à lire des textes d’apprentissage de la voix la plus monocorde possible à la nouvelle version d’un soft, et puis abandonné devant ses piètres performances. Ca ne marche pas, ou pas assez bien.

Robert Portner analyse cet échec dans « Rest in Peas: The Unrecognized Death of Speech Recognition« , titre subtilement traduit en français dans le présent article.

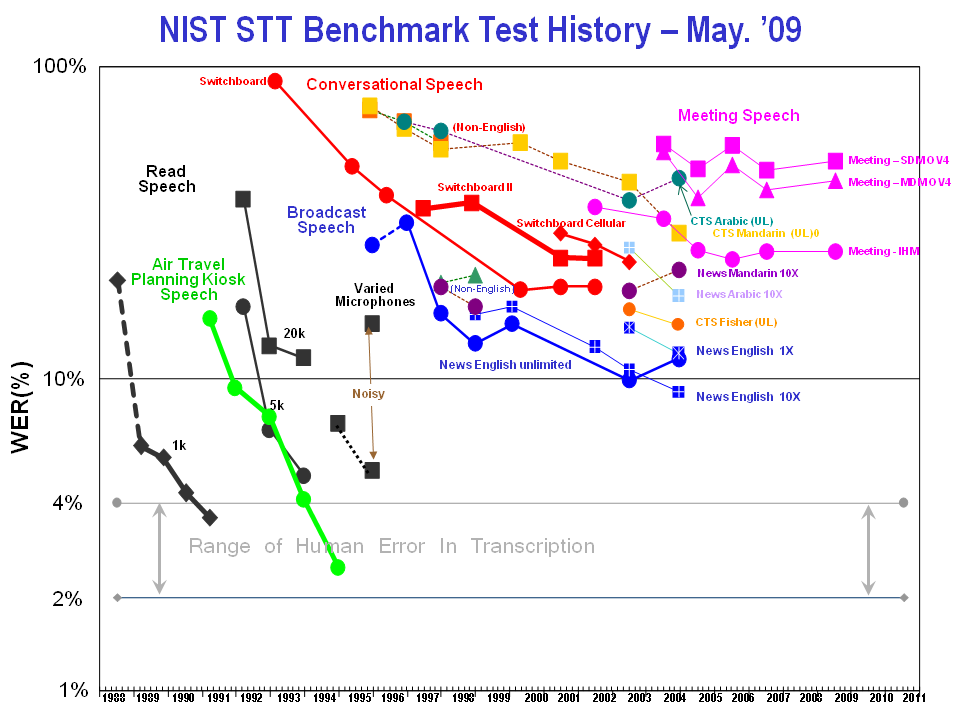

Le problème, c’est qu’après une phase de progrès rapides à la fin du siècle passé, le taux d’erreur de mots plafonne à 10% depuis 2001 , soit environ le triple du taux d’erreur d’un être humain. Et encore, c’est pour l’anglais « standard ». Le taux d’erreur est bien plus élevé pour d’autres langues, et catastrophique pour une conversation entre supporters de foot à la sortie du match.

Pourtant dans les années 1990, des systèmes très fiables avaient été mis au point pour distinguer quelques mots bien choisis dans des cockpits d’avion ou des chiffres au téléphone, et on s’était légitimement attendus à ce que la Loi de Moore permette de traiter rapidement le langage naturel. Et effectivement, aujourd’hui on sait bien reconnaitre des mots isolés. On sait à peu près éliminer les absurdités non conformes à la grammaire dans des phrases simples comme « le chat ment je la sous rit. » Mais pour distinguer entre « le chas mange la souris », « le chat mange là, sous l’riz » et « le chaman gela, sourit » et , il faut comprendre le sens de la phrase, voire le contexte dans lequel elle est prononcée…

Si l’ordinateur doit connaitre la différence entre un quadrupède carnivore et le trou d’une aiguille pour traiter une phrase triviale, on imagine que ce n’est pas demain qu’on dictera des contrats* ou des rapports à une machine. De gros projets ont été lancés par des poids lourds de l’informatique pour tenter de modéliser la connaissance humaine. Par exemple le projet MindNet de Microsoft [2] a analysé des millions de pages de textes existants pour construire un graphe sémantique gigantesque, duquel il ressort effectivement que dans une phrase comportant « chat » et « souris », le plus probable est que le chat chasse la souris. Un tel graphe peut certainement être utile en traduction automatique car on dispose d’un texte de départ, mais pour la reconnaissance vocale il faudrait étendre le graphe à la structure des phrases utilisées en conversation courante, qui peut être bien distincte du langage écrit. Et pour faire ça automatiquement, il faudrait la reconnaissance vocale…

Comme le note Portner, on pensait au début que la reconnaissance vocale était un premiers pas vers l’intelligence artificielle. Aujourd’hui de nombreux chercheurs estiment que l’intelligence artificielle est indispensable pour atteindre une reconnaissance vocale de qualité acceptable [2]. Les gros projets de recherche ont été abandonnés les uns après les autres, bloqués devant le mur si bien décrit par les Perlisismes sur l’intelligence artificielle comme:

« Une année de travail sur l’intelligence artificielle est suffisante pour vous faire croire en Dieu »

Le nombre de recherches sur « reconnaissance vocale » ou « Dragon Naturally Speaking » sur Google baisse régulièrement depuis 2001. Comme aucune idée fondamentalement nouvelle ne vient relancer la recherche, la reconnaissance vocale est morte, en toute discrétion.

Note* : me rappelle l’histoire de la secrétaire d’un célèbre ingénieur de la génération disctaphone qui avait commandé « 310 mètres d’isolation entre 2 étages » au lieu de « 3 centimètres » . Ca c’est avec les 2% d’erreurs de transcription humaines…

Références:

- The History of Automatic Speech Recognition Evaluations at NIST

- Microsoft Research : MindNet

-

Janet M. Baker et al. » Research Developments and Directions inSpeech Recognition and Understanding« , IEEE Signal Processing Magazine [75] MAY 2009

20 commentaires sur “La reconnaissance vocale est morte : pet à son âme.”

Ok, il y a des fois où il faut reconnaître s’être trompé. Je me suis trompé. Après une longue période de stagnation, la reconnaissance vocale a fait des progrès spectaculaires et rapides ces derniers temps, résumés dans http://www.nouvo.ch/2011/12/reconnaissance-vocale-gadget-ou-r%C3%A9volution

Bonjour,

Je me faisais un peu la même réflexion dernièrement…

Cependant, il est à noter que dans le domaine médical, la dictée électronique se développe quand même de plus en plus…(les médecins dictant leur compte-rendu à l’ordinateur, économisant ainsi du temps de secrétaires).

Finalement, la question est de savoir quel est le niveau de fiabilité requis et comment l’atteindre. L’ingénieur de la note figurant au base de l’article relisait en diagonale le document tapé par sa secrétaire, mais la confusion entre « 3 centimètres » et « 310 mètres » est passé à travers. Elle était tellement aberrante que ça n’a pas eu de conséquence. Mais on pourrait imaginer un équivalent médical plus dramatique… Les médecins relisent-ils ce qu’ils ont dicté à leur ordi, ou lui font-ils plus confiance qu’à leur secrétaire ?

Je viens de tomber sur cet article dans Slate :

http://www.slate.fr/story/36797/saisie-texte-reconnaissance-vocale

Résumé de l’article : Grâce à toutes ses données vocales, Google arrive à obtenir de très bon résultats en reconnaissance vocale. Les systèmes basés sur la description physique des phonèmes prononcés sont insuffisants car la variabilité est immense entre les locuteurs ou par ce qu’un même phonème sera prononcé différemment en fonction du phonème précèdent même si c’est imperceptible à l’oreille humaine.

En y réfléchissant, j’ai l’impression que Google fait ce que fait réellement notre cerveau au quotidien : Enfants, notre cerveau apprend des sons, des formes, des odeurs, etc… et ensuite ils compare les nouveaux stimulus avec ce qu’il a gardé en mémoire et réactualise sa base de donnée en permanence. Il fait lui même sa propre analyse statistique. C’est peut être pour cela que l’on a du mal au début à comprendre une personne avec un très fort accent (par rapport à son propre accent). J’ai souvenir un jour d’un reportage « dans la France profonde » où la personne interviewée était sous-titrée tellement son accent était dur à comprendre alors que la syntaxe était tout à fait correcte.

Et c’est peut être aussi pour cela que l’on arrive aussi à le gruger avec des illusions d’optiques par exemple.

oui je dois dire que je suis estomaqué par la performance de la reconnaissance vocale sur mon téléphone Android (Nexus S) . Google a manifestement réussi une percée dans le domaine. Je vais faire quelques recherches et tests pour voir quel taux d’erreur on atteint, et si ça marche an français aussi bien qu’en anglais…

Merci pour le lien vers l’article, très intéressant bien que pas assez technique à mon goût.

Et ils font pareil avec Google Translate:

http://www.slate.fr/story/46103/outil-google-traduction-puissant

D’un autre côté, il y a aussi http://www.linguee.fr/ fait par des anciens de Google justement qui lui aussi se base sur les textes traduits de l’ONU. Je me demande si les deux sociétés entretiennent on non des relations.

Par contre, j’ai une réserve sur l’article que je point sur le passage suivant :

Ces innombrables «ressemblance familiales» sémantiques coulent de source pour les humains. Et nous pouvons de toute évidence les enseigner aux machines –il suffit pour ce faire de réunir plus de données. Google est le premier à avoir eu l’idée de mettre cette idée en pratique, réalisant par là-même un progrès significatif. Les ordinateurs ne se contentaient plus de déchiffrer la syntaxe: ils pouvaient comprendre le sens d’une phrase dans toute sa force, avec une intelligence capable de s’adapter à chaque contexte.

Je ne pense pas que Google soit le premier à avoir l’idée. Par contre c’est le premier qui a les bases de données et les serveurs qui vont avec pour exploiter l’idée. Une start-up aurait du mal à le faire elle même : il faut quelques développeurs pour développer l’ago de base, mais des terra octets de données avec les algos de recerche optimisés de Google pour avoir un résultat décent dans un temps raisonnable.

J’attends avec impatience le couplage Google Translate + Reconnaissance vocale + Moteur de synthèse vocale pour la traduction à la volée sur smartphone d’une conversation de n’importe quelle langue vers n’importe quelle autre langue 🙂

Comme pour Google Maps, au début cela sera gratuit, puis un jour, cela deviendra payant quand on dépassera X requêtes par jour 🙂 Un bon dealer sait donner sa drogue pour rendre accroc avant de la vendre !

NTT Docomo travaille intensivement sur ce problème.

Ils ont dévoilé un prototype fonctionnel en 2011, et entendu à d’autres langues il y a peu.

Une réaction m’est parvenue par une voie détournée. Yves avait republié (avec mon autorisation) cet article dans le bulletin de l’ASPEDA , l’Association Suisse des Parents d’Enfants Déficients de l’Audition (http://www.aspeda.ch/IMG/pdf/Nr_5_2010.pdf ). Il a reçu une lettre très intéressante de la part des personnes responsables du sous-titrage à la Radio Télévision Suisse Romande, que je copie ci-dessous avec l’aimable autorisation des auteurs:

Cet article est mon premier re-publié sur Ownisciences, mais pas le dernier…

En parlant de l’odyssée de l’espace, HAL le vilain ordinateur sait même lire sur les lèvres! En effet, à un moment les astronautes s’isolent dans une capsule pour discuter loin des micros de HAL (alors qu’avec un systèem de reconnaissance vocal il suffirait de chuchoter ou de parler en argot). On voit HAL suivre la conversation via son œil rouge, fixant tour à tour les lèvres des deux astronautes…

Rigoureusement impossible. Un sourd performant en lecture labiale décode 30% du message (c’est moins en anglais) et le reconstitue par suppléance mentale.

« Rigoureusement impossible » est une expression dangereuse, mon cher Yves 😉 Mais la lecture labiale me semble en effet un excellent exemple du problème : l’humain est capable de reconstituer un message parlé « haut niveau » en n’en captant que 30% du « bas niveau ». Du point de vue de la théorie de l’information, on peut en déduire soit (ou à la fois) que notre langage est très redondant ou qu’on parle pour ne rien dire, puisque le sens peut être reconstitué par « suppléance mentale », qui me semble reposer sur la « connaissance du contexte ».

A ce propos, je m’amuse des fois à espionner les conversations de personnes que je ne vois pas, la table d’à côté au resto ou les gens derrière moi dans une soirée. Noyée dans le bruit, j’ai remarqué qu’il me faut écouter plusieurs de leurs phrases souvent incompréhensibles afin de capter quelques mots qui permettent de saisir le sujet, suite à quoi je les comprends de mieux en mieux…

« Dans la symbiose homme-machine, c’est l’homme qui doit s’adapter parce que la machine ne peut pas. » (Alan Perlis)

« Rigoureusement impossible »… Cela me fait penser à une expression de feu Lucien Berrebi, professeur de physique et ami d’enfance de mon père, qui disait à peu près: « quand j’entends impossible n’est pas français, je propose de vider un dentifrice puis de le remplir pour revenir à l’état initial en passant par le même orifice ».

Bon, ok « impossible » peut être thermodynamique. Reste à trouver le lien entre français et thermodynamique…

Il y a aussi le génial romancier Richard Powers, qui dicte tous ses romans allongé depuis son lit:

http://query.nytimes.com/gst/fullpage.html?res=9900E3DC1F31F934A35752C0A9619C8B63

(ceci est un message d’un grand fan de Richard Powers, que tous les lecteurs de ce blog devraient s’empresser de découvrir…)

Intéressant, mais je connais le contre-exemple: Yann Gourvennec (auteur du blog: http://visionarymarketing.com/fwelcom.html) dicte ses articles sur Dragon, puis les retouche rapidement à la main. Cela lui permet d’être beaucoup plus rapide que nombre de blogueurs…

En effet, jolie traduction du titre 🙂

Shazam ça fonctionne quand même bien.

Très bonne remarque. En effet mon article « Comment marche Shazam » semble montrer le contraire de celui-ci. Mais le problème est très différent. Dans Shazam, on compare un enregistrement (certes bruité voire déformé) à lui même. Dans la reco vocale, on ne peut pas faire de base de données des 10^150 phrases grammaticalement possibles prononcées par des millions de gens dans des milliers de circonstances différentes, donc on est obligés de faire de la reconnaissance phonétique de chaque mot. Et c’est là qu’apparait le véritable problème, décrit dans l’article : on ne peut pas aligner des mots sans comprendre le sens de la phrase…

moi j’aimais bien mon très vieux nokia 3310 qui reconnaissait un nom pre enregistré pour composer un appel. Ces fonctions ont disparues des telephones puis commencent à réapparaitre.

A l’époque où j’écrivais mon livre j’avais utilisé le programme de reconnaissance de texte IBM; la version mot-à mot, moins naturelle me semblais plus sûre… Effectivement j’ai aussi laissé tomber ce système – même si je tape au clavier à 3-4 doigts.

Cependant, on dirait que IBM persiste:

http://www.zdnet.fr/actualites/watson-le-superordinateur-d-ibm-va-participer-au-jeu-jeopardy-39752548.htm#xtor=RSS-1